Anthropic 在最新的技术博客中一针见血地指出:那些让 Agent 变得有用的能力——自主性、灵活性和多步推理,恰恰也正是它们难以被评估的原因[1]。这个悖论正在困扰着整个 AI 行业:我们如何才能真正衡量一个智能体在真实世界中的表现?某种意义上,评测的边界,决定了我们能看到的智能的上限。

当大模型从简单的对话框走向能够自主决策的智能体(Autonomous Agents),我们面临着一个紧迫的现实:Agent 的能力在飞速进化,但我们的“考题”却滞后了。仅仅依靠单轮对话或短文本“玩具”任务,已无法衡量一个智能体在真实工作流中的表现。想要看到智能的真正边界,就必须先拓展评测的边界。

今天,上海创智学院/上海交通大学 GAIR Lab 团队发布了最新基准测试AgencyBench V2。此次发布迎来了指数级的进化:从 V1 版本[2]仅有的 10 个验证性任务,全面跃升至覆盖 138 个真实世界场景(Real-world Tasks),且支持无需人工干预的全自动化评估。

这不仅是一份考卷,更是一次对现有 Agent 虚假繁荣的“降维打击”。报告指出:真正的自主智能,必须直面 百万级 Token 上下文、近百次工具调用以及 数小时长程规划 的真实世界残酷考验。评测的边界每拓展一步,我们就能看清智能体离真正的自主还有多远。

在这场“地狱级”大考中,AgencyBench 揭示了当前 AI 格局的残酷真相:

·框架“偏科”严重:模型普遍存在“主场优势”,在自家原生开发框架(Scaffold)中表现远超通用环境,泛化能力不足。GPT-5.2在OpenAI-AgentsSDK上领先Claude-Agent-SDK 5.2%,而Claude-4.5-Opus在Claude-Agent-SDK上领先 20.5%。

·“暴力美学” vs “性价比”:GPT-5.2 推崇高消耗换取一次成功的“暴力美学”,而 Grok-4.1-Fast 则是资源受限下的“性价比之王”。

·“话痨”的代价: Claude-4.5-Sonnet 陷入无效消耗陷阱,Token 消耗全场最高,却未能转化为相应的性能提升。

一、告别“玩具”时代:为什么我们需要更难的基准?

过去两年,我们见证了许多Agent基准的诞生。但仔细审视,它们大多存在一个致命缺陷:轨迹不够长、场景不够真实、评估依赖人工。

现有的Benchmark往往聚焦于单一能力(如单纯写个Python函数),或者依赖“人机协同”的反馈回路(比如Arena类型的评测)——这在规模化评估时成为了巨大的瓶颈。

我们认为:“如果一个Agent只能解决几百个Token的玩具任务,它永远无法真正进入经济生产环节。”

为了填补这一鸿沟,AgencyBench 应运而生。它不是为了刷榜而设计的,而是为了模拟真实的人类工作流。

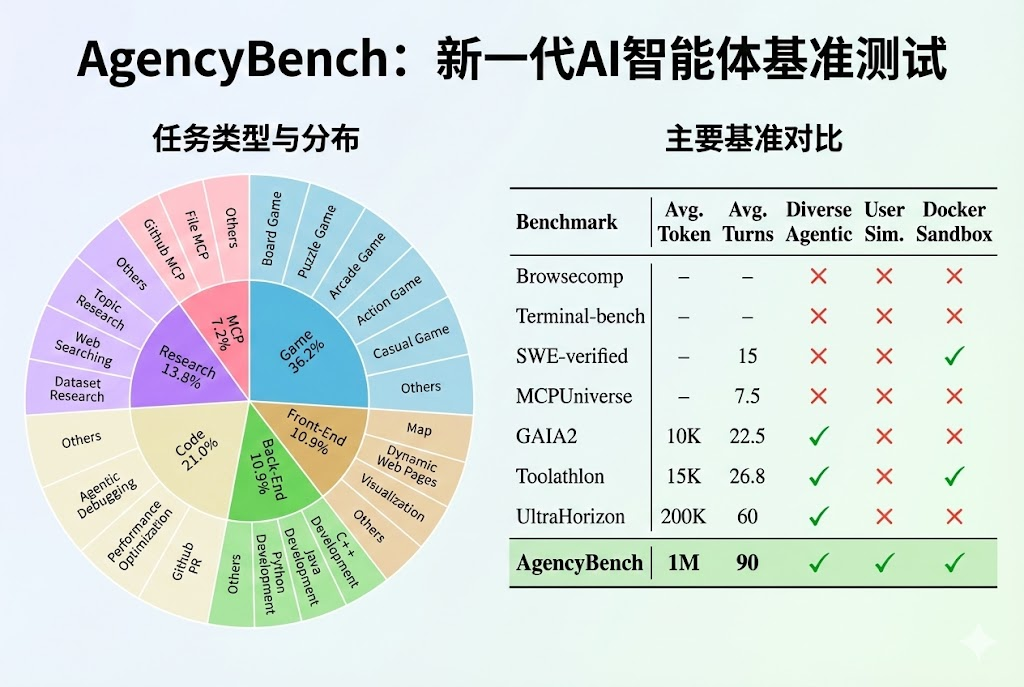

图注: AgencyBench 与现有基准的对比。左侧展示了其涵盖的6大核心能力与32个真实场景;右侧数据显示,相比其他基准,AgencyBench在Token消耗量(平均1M+)和工具调用次数(平均90+)上呈现出数量级的提升。

图注: AgencyBench 与现有基准的对比。左侧展示了其涵盖的6大核心能力与32个真实场景;右侧数据显示,相比其他基准,AgencyBench在Token消耗量(平均1M+)和工具调用次数(平均90+)上呈现出数量级的提升。

二、AgencyBench:百万Token的炼金术

AGencyBench 的核心设计哲学是 “真实(Authenticity)” 与 “长程(Long-horizon)”。

团队邀请了20位人类专家,包括AI研究员、活跃的开发者,构建了32个真实的复杂场景,共包含138个具体任务。这些任务覆盖了6大核心领域:

·游戏开发 (36.2%):从零开始写一个五子棋(Gomoku)游戏,包含UI、逻辑、AI对战。

·代码开发 (21.0%):解决复杂的算法和工程问题。

·Web/学术研究 (13.8%):像人类研究员一样查阅文献、总结综述。

·全栈开发 (21.8%):前端与后端的深度结合。

·MCP工具使用 (7.2%):适应最新的模型上下文协议。

这就带来了一个巨大的挑战:如何评估?

如果是简单的问答,对比答案即可。但如果Agent生成了一个复杂的网页或游戏,怎么判断它是对的?

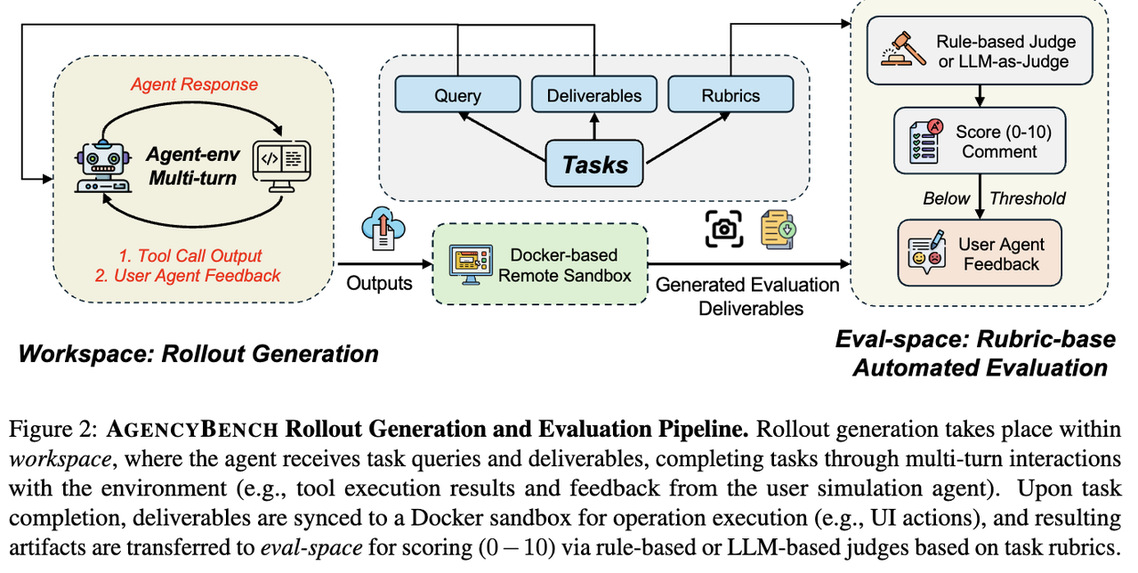

团队提出了一套 “全自动评估流水线”,包含两个杀手锏:

1.用户模拟Agent(User Simulation Agent):不需要人类盯着屏幕,由一个专门的Agent扮演甲方用户,提供持续的反馈和修改意见,解决“人类瓶颈”问题。

2.Docker沙箱+多模态裁判:所有的代码都在隔离的Docker容器中运行,不仅检查代码跑不跑得通,还通过 视觉裁判(Vision-based Judge) 去“看”生成的网页布局对不对,游戏能不能玩。

图注: AgencyBench 的自动化评估流水线。Agent在独立的工作区(Workspace)中干活,用户模拟Agent提供反馈,最终的产物被同步到Docker沙箱中运行,由视觉和文本裁判打分。

图注: AgencyBench 的自动化评估流水线。Agent在独立的工作区(Workspace)中干活,用户模拟Agent提供反馈,最终的产物被同步到Docker沙箱中运行,由视觉和文本裁判打分。

三、谁是“最强打工人”?闭源模型 vs 开源模型

在AgencyBench这个“地狱级”难度的考场上,各大模型的表现如何?

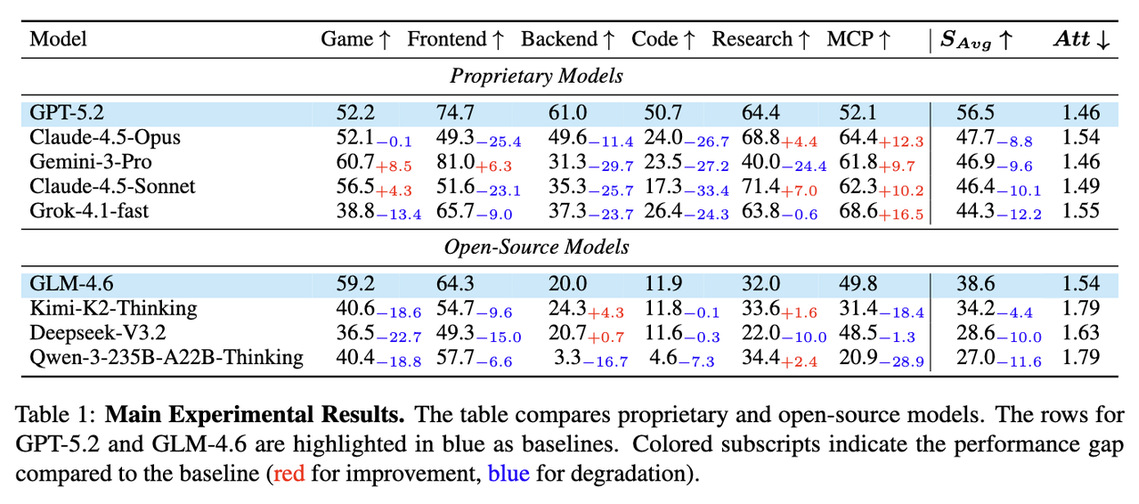

实验结果揭示了当前AI格局的残酷真相:闭源模型依然拥有绝对的统治力。

·第一梯队:OpenAI的 GPT-5.2 以 56.5% 的平均分夺冠,Claude-4.5-Opus 紧随其后。

·开源之光:GLM-4.6 以 38.6% 领跑开源模型,但与闭源SOTA相比仍有近20分的差距。

·长尾困境:即使是最强的模型,在面对需要数十次迭代、百万Token上下文的任务时,成功率依然不到60%。这意味着,距离真正的“全自动AI员工”,我们还有很长的路要走。

图注: 主实验结果一览。GPT-5.2 在后端开发和代码能力上表现出色,而 Claude-4.5-Sonnet 则在研究领域(Research)展现了惊人的统治力(71.4%)。

图注: 主实验结果一览。GPT-5.2 在后端开发和代码能力上表现出色,而 Claude-4.5-Sonnet 则在研究领域(Research)展现了惊人的统治力(71.4%)。

四、深度洞察:模型也有“性格”、“主场优势”与“经济账”

除了硬核的得分排名,AgencyBench 的实验数据还像显微镜一样,挖掘出了大模型在解决复杂任务时许多有趣的“潜意识”行为和经济学特征。

01 生态系统的“主场优势”

只要给模型配上它“原生”的工具包(Scaffold),它的表现就会突飞猛进。 实验发现,Claude-4.5-Opus和GLM4.6 在使用自家适配的 Claude-Agent-SDK 时,性能相比通用的Agent框架分别暴涨了 20.5% 和 10.6%; GPT-5.2 在使用自家适配的OpenAI-AGents-SDK时,性能相比Claude-Agent-SDK提升了5.2%。这揭示了一个被忽视的真相:Agent的能力不仅取决于模型本身(Model-intrinsic),更取决于模型与框架的“契合度”。对于开发者而言,这就像是给赛车手配上了专属座驾,选对“装备”往往比单纯升级模型更重要。

02 算力经济学:谁是“性价比之王”?

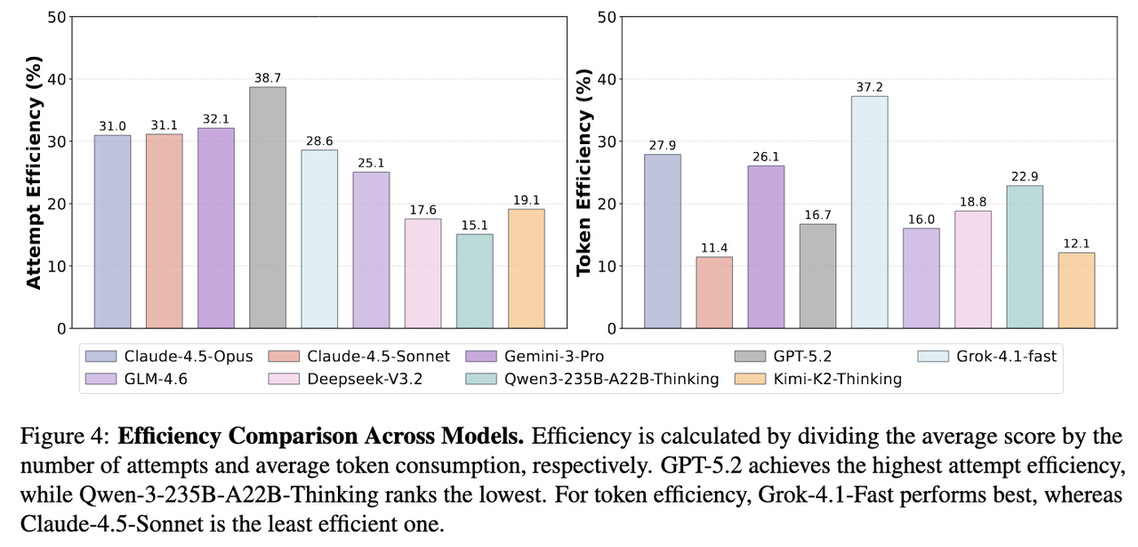

在真实生产环境中,不仅要看“能不能做出来”,还要看“花了多少钱”。AgencyBench 引入了 尝试效率(Attempt Efficiency) 和 Token效率(Token Efficiency) 两个维度,帮企业算了一笔经济账。

·“暴力美学”的顶级专家(GPT-5.2): GPT-5.2 拿下了最高的尝试效率 (38.7%)。它就像那种虽然收费贵、但绝不返工的资深专家。虽然它平均每个任务要消耗惊人的 340万 Token,采用“大力出奇迹”的推理方式,但它在每一轮尝试中的成功率极高。如果你追求“一次把事做对”,它是首选。

·“极速省钱流”的快刀手(Grok-4.1-Fast): 它是Token效率 (37.2%) 的冠军。平均仅消耗 120万 Token 和 0.3小时 就能完成任务。虽然绝对分数不如GPT-5.2,但它在有限的资源下产出极高,是资源受限环境下的“最具经济效益”选择。

·“话痨”的代价: 相比之下,Claude-4.5-Sonnet 显得有些“铺张浪费”。它平均消耗了 410万 Token(全场最高),但Token效率却垫底(11.4%)。这说明它生成了大量冗余的思维链或无效尝试,却没有换来同比例的性能提升。

图注: 不同模型的效率对比。左侧显示 GPT-5.2 在尝试效率上一骑绝尘;右侧显示 Grok-4.1-Fast 在Token使用效率上最具优势,通过“少花钱多办事”脱颖而出。

图注: 不同模型的效率对比。左侧显示 GPT-5.2 在尝试效率上一骑绝尘;右侧显示 Grok-4.1-Fast 在Token使用效率上最具优势,通过“少花钱多办事”脱颖而出。

03 “领航员”vs“执行者”:工具调用的MBTI

在使用工具调用来解决问题时,不同模型展现出了截然不同的性格:

·慎重的“领航员”(GLM-4.6): 它像一位谨慎的工兵,疯狂调用 list_directory 工具(次数是其他模型的3倍)。它倾向于先彻底摸清环境目录结构,再小心翼翼地动手。

·自信的“执行者”(GPT-5.2): 它则像一位自信的黑客,偏好直接运行Shell命令(run_shell_command 调用425次) 。它更喜欢通过运行代码来验证假设,通过“试错”来推进任务,甚至像外科医生一样精准地使用 replace 工具修改代码片段 ()。

·拥有“外脑”的智者(Gemini-3-Pro): 它是全场唯一一个真正会用“记事本”的模型。数据表明,只有它频繁调用内存管理工具(update_memory_bank) ,试图把关键信息存入外部记忆,而不是单纯依赖上下文硬抗。这种行为模式对于解决超长程任务具有极高的潜力。

五、结语:通往AGI的最后几公里

AgencyBench 的发布,不仅是一个排位赛,更是一面镜子。

它照出了大模型在面对真实世界超长任务时的窘境:资源消耗巨大、自我修正能力不足、对特定工具环境的依赖。

但这正是进步的开始。

AgencyBench 不仅是一个排行榜,更是一个诊断工具。 当我们的Agent能够在这个基准上从容应对百万Token的挑战时,或许我们才可以说,AI真正走出了实验室,走进了我们的生活。

未来的Agent,不仅需要更强的大脑(模型),更需要更适应它的身体(Scaffold)和更懂它的环境(Context)。

评测本身不是终点,而是指引进化的罗盘;只要智能的演进没有停止,对“真实”的度量就永远在路上。

论文标题:AgencyBench: Benchmarking the Frontiers of Autonomous Agents in 1M-Token Real-World Contexts

项目主页:https://agencybench.opensii.ai/

论文链接:https://github.com/GAIR-NLP/AgencyBench/blob/main/AgencyBench.pdf

Github链接:https://github.com/GAIR-NLP/AgencyBench

Huggingface链接:https://huggingface.co/datasets/GAIR/AgencyBench

[1] Demystifying evals for AI agents: https://www.anthropic.com/engineering/demystifying-evals-for-ai-agents

[2] https://github.com/GAIR-NLP/AgencyBench/tree/main/AgencyBench-v1