当前,全球AI竞争日趋激烈。在最高难度AI评测中霸榜,全球TOP10模型中8个未开源,核心基础设施遭遇封锁。AGI的火种正被少数力量垄断。我们的回应是:以开源生态打破壁垒,以实干人才推动普惠。

因此,我们正式启动“创智AI基础设施开源周”活动,发布五大核心项目,涵盖下一代训练框架、推理引擎、万卡集群通信库与智能运维系统。

一、项目亮点

1. 非 GPU 架构芯片 : 原生 TPU 支持

2. Native AI Compiler : XLA 编译全计算过程

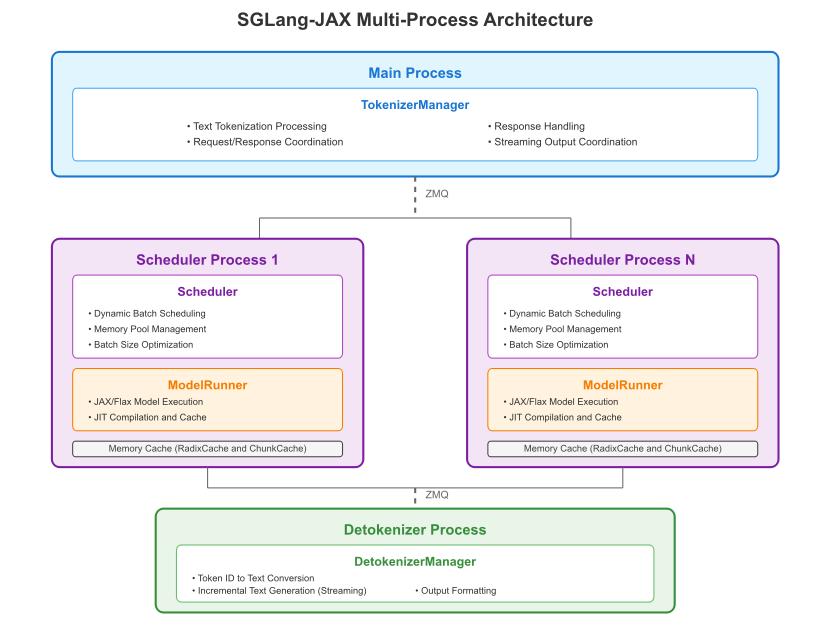

二、架构概览

开源代码仓库:https://github.com/sgl-project/sglang-jax

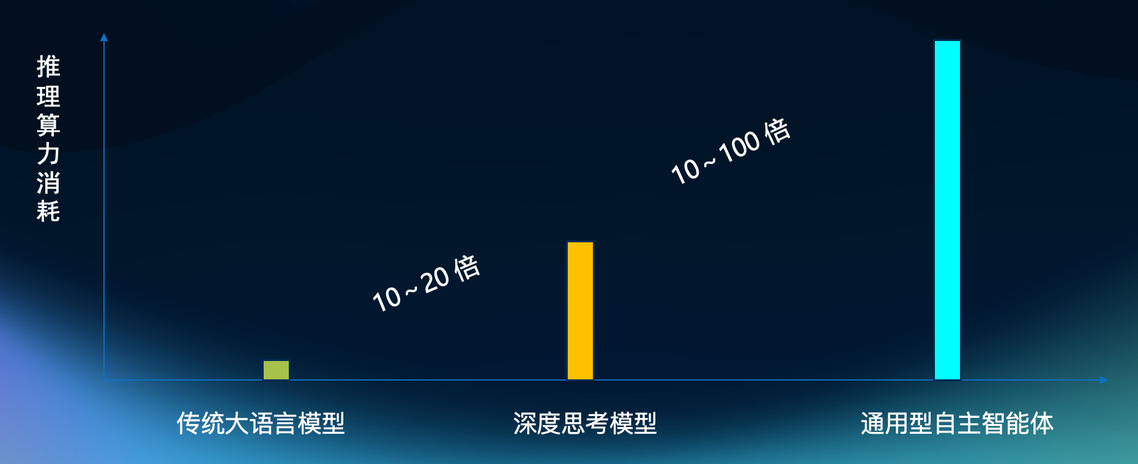

随着智能体与AI应用爆发,推理算力需求激增(过去几年增长千倍)。鉴于对极致推理性能的需求日益增长,我们选择 JAX 作为框架,旨在利用其基于 XLA 的成熟的编译优化能力, 去探索硬件、编译器与框架的系统性迭代最优解,一个核心问题摆在我们面前:我们能否构建一个统一、高效且面向未来的大模型推理系统?

今天,我们发布一个全新的开源项目:sglang-jax 。这不仅是一个推理引擎的诞生,更是一场关于未来大模型系统架构探索的开端。我们期望 sglang-jax 能成长为一个以 JAX 为核心的统一计算框架,初步在 Google TPU 上进行性能验证,并计划在未来将我们的探索延伸至 GPU 等更多硬件平台。

2.1 当前进展:我们迈出的第一步

为了让社区能够更好地参与和贡献,我们在此分享项目当前的具体进展。在早期阶段,我们已经搭建了推理引擎的核心框架,并实现了一些关键特性:

连续批处理 (Continuous Batching): 我们初步实现了一个智能调度器,旨在通过动态批处理传入请求,最大化硬件利用率和整体吞吐量。

Radix 树 KV 缓存: 为了高效管理内存,我们引入了 Radix 树进行 KV 缓存管理,它能够实现请求间的有效前缀共享,显著节省内存。

已支持模型:我们从支持 Qwen 系列模型开始,并已具备良好的扩展性,未来将支持更多模型。当前已优化支持:

Qwen 2.5, Qwen3, Qwen 3 MoE

2.2 JAX的力量:我们选择它,是选择了可能性

我们为什么选择 JAX 作为这场探索的基石?这是一个关乎未来的战略性决策。

原生的分布式语义:我们相信 JAX 内置的分布式原语,能让我们以更优雅、更统一的方式来思考和实现跨硬件的并行计算,这是项目未来能够适应异构环境的关键。

完整且强大的编译器生态:JAX 与 XLA 编译器的深度融合,为我们打开了一扇通往底层优化的窗户。我们期望能借助这个生态,在未来进行更深度的软硬件协同设计。

2.3 育人之道:播下一颗种子,期待一片森林

一个开源项目的生命力,源于其社区与愿景。sglang-jax 的种子刚刚种下,我们热切期望它能成长为一个开放的、系统性的探索与学习平台。

我们希望 sglang-jax 能成为一个“开源实验室”,吸引高校的师生和业界的研究者,共同在这里进行前沿的系统性探索:

- 我们能一起探索异构硬件的分布式计算吗?

- 我们能共同研究模型结构与硬件微架构的系统性优化吗?

- 我们能将这里作为验证AI 编译器新思路、新方法的试验田吗?

我们期待在社区内形成迭代与反馈的正向循环。您的每一次尝试、每一个 Issue、每一个 PR,都是对这个项目最宝贵的灌溉。学术界的前沿思想可以流入 sglang-jax,使其进化;而一个不断进化的 sglang-jax,又能为科研和学习提供更强大的工具。

2.4 致谢

sglang-jax 的诞生与起步,离不开开放协作的社区精神。我们在此特别感谢 sglang 社区,这个项目是我们共同努力的成果。非常感谢 Ying 在过程中给予的关键支持与帮助!同时,也由衷感谢 Google 相关同事在项目探索阶段提供的宝贵支持和指导。

2.5 未来蓝图 (Roadmap)

我们为 sglang-jax 规划了清晰的迭代路径,并希望与社区共同实现。长期探索方向:

- 更广泛的模型支持 (Model Support):Qwen, Llama, Mistralai, Grok-2, DeepSeek 等主流模型。

- 深化 TPU 性能优化与普及 (Pallas / TPU Recipe):

深入探索 TPU 微架构特性,释放硬件极致潜力。

我们计划推出 “如何一步步编写高性能 Kernel” 的教程,赋能社区开发者。

- 强化学习与开发生态支持 (RL & Tunix):

探索对强化学习训练与推理场景的支持。

2.6 2025年Q4 初步计划

- MTP

- Quantization

- Prefill-Decode 分离: 针对 LLM 推理的专项性能优化。

- JAX on GPU 支持 (探索中, TBC)

- 多模态模型支持 (探索中, TBC)