当前,全球AI竞争日趋激烈。在最高难度AI评测中霸榜,全球TOP10模型中8个未开源,核心基础设施遭遇封锁。AGI的火种正被少数力量垄断。我们的回应是:以开源生态打破壁垒,以实干人才推动普惠。

因此,我们正式启动“创智AI基础设施开源周”活动,发布五大核心项目,涵盖下一代训练框架、推理引擎、万卡集群通信库与智能运维系统。

siiRL:全分布式架构的颠覆性突破

上海创智学院AI Infra团队发布siiRL 2.0,聚焦性能、生态与前沿探索全面升级:

1. 卓越性能与扩展性:基于全分布式架构,实现千卡级近线性扩展与业界领先吞吐,性能在7B~235B(Dense/MoE)等大规模模型上稳定验证。

2. 自主可控,拥抱国产算力:全面适配多家主流国产芯片并完成千卡级扩展验证,为AI基础设施夯实自主可控的算力底座。

3. 灵活易用与生态兼容:独创DAG工作流支持无代码算法实验,兼容Megatron/FSDP等主流后端,极大提升研发效率。

4. 面向前沿,支持多智能体研究:内建强大的多智能体协同训练框架,为探索“智能涌现”等前沿课题提供关键基础设施。

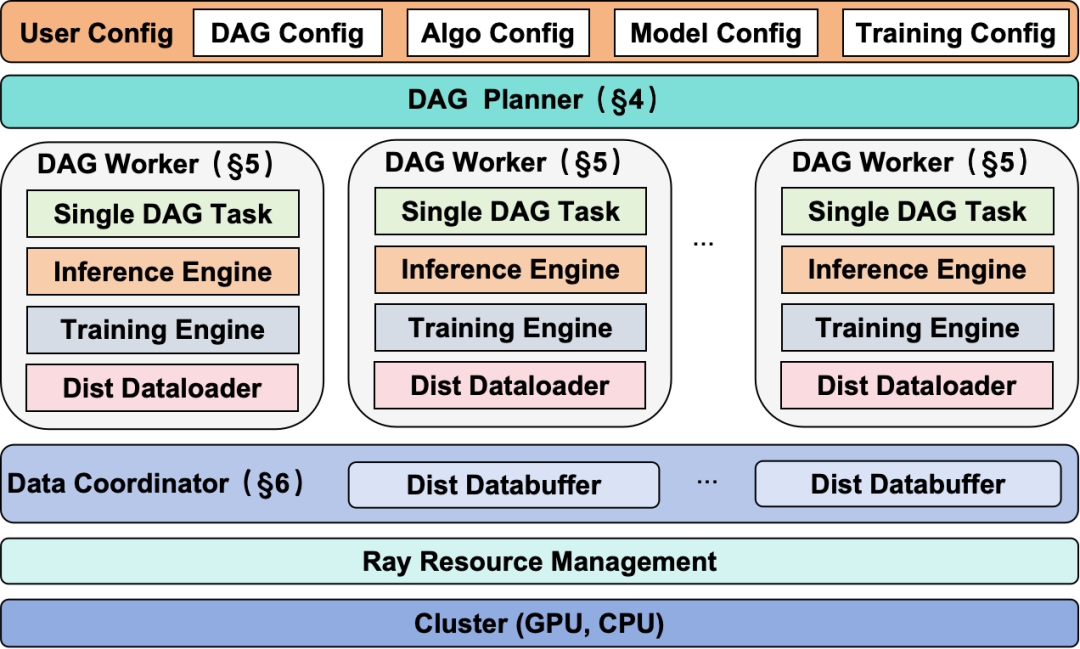

图 1:siiRL架构概览

图 1:siiRL架构概览

技术论文: https://arxiv.org/abs/2507.13833

开源代码仓库:https://github.com/sii-research/siiRL

一、国产化适配:首个实现强化学习国产千卡集群高效扩展

强化学习(Reinforcement Learning, RL)作为人工智能领域的前沿技术,已在机器人控制、自动驾驶、多智能体系统等复杂决策任务中展现出巨大潜力。然而,这些尖端应用的实现,高度依赖于底层计算硬件与上层算法框架的深度协同。在当前国产化浪潮下,一个突出的挑战是业界主流强化学习框架对国产硬件生态的普遍支持不足:其官方支持大多集中于英伟达等少数厂商,这种“点状”支持模式,使得广大用户在国产计算平台上部署和扩展强化学习应用时面临重重阻碍,不仅增加了适配难度,也限制了强化学习技术在更广泛国产算力上的应用与发展。

今年7月24日我们已开源了siiRL 1.0版本,在NVIDIA GPU上取得SOTA计算效率以及千卡级线性扩展。相较于基准NVIDIA GPU,国产卡在单卡算力、显存容量及卡间通信带宽等方面存在一定差距,这对大规模分布式训练的扩展性构成了直接挑战。为了打破这一生态瓶颈,真正释放国产算力的潜力。今天我们正式启动了 siiRL 2.0 的全面升级,并针对华为昇腾、沐曦及平头哥等主流国产计算卡开展了框架的适配与优化工作。

为解决这些硬件特性差异带来的瓶颈,我们进行了一系列针对性优化:

算子替换与框架优化:针对国产卡的计算特性,替换了包括 rotary_pos_emb、rmsnorm 在内的关键高性能算子,并引入 vllm-ascend 等框架的优化技术,通过算子层与框架层的联合调优,实现了计算效率的显著提升。

内存优化策略调整:结合显存的实际负载,调整gpu_memory_utilization、enable_gradient_checkpointing等配置,充分利用硬件的显存,以实现计算效率的进一步提升。

分布式策略调整:结合实际负载与硬件拓扑,优化了不同模型的分布式训练参数切分方式,并调整了亲和性配置,以提升通信效率。

硬件驱动层适配:面对国产卡在驱动及配套计算库上的生态差异,我们完成了对昇腾、沐曦、平头哥等异构硬件驱动栈的适配工作,确保了框架运行的底层稳定性与兼容性。

通过上述优化,siiRL框架在国产卡集群上实现了从32卡到1024卡的稳定扩展,系统保持了超过90%的高线性度拓展效率。在模型精度上,与NVIDIA GPU的训练结果相比,国产卡集群在验证集上的平均绝对误差控制在0.5%以内,满足实际应用场景的精度要求。此项工作在国内首次完成了强化学习在国产千卡集群上的规模化验证与应用。

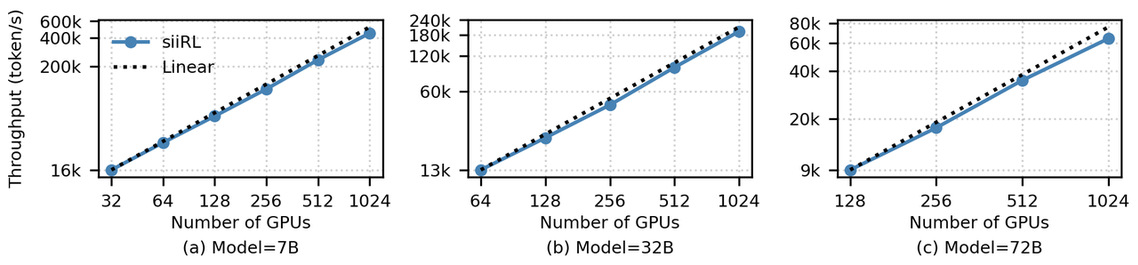

图 2:siiRL在国产卡上不同规格任务的扩展性评估,展示了从32到1024 GPU规模下的高线性扩展能力

图 2:siiRL在国产卡上不同规格任务的扩展性评估,展示了从32到1024 GPU规模下的高线性扩展能力

二、多智能体协同训练:增强交互与实时反馈能力

在复杂任务处理领域,多智能体系统凭借 “分工协同、各擅其长” 的核心优势,展现出远超单智能体的能力上限 —— 在 GAIA 人工智能排行榜中,得分领先的系统亦多为多智能体架构。这一趋势直接推动了多智能体协同训练需求的持续攀升,尤其在现实场景中,任务的复杂性往往要求智能体通过与环境动态交互实现工具调用、动态决策,最终逐步完成目标,进一步凸显了高效协同训练方案的必要性。

然而,当前主流强化学习框架对多智能体协同训练支持不完善,难以满足实际应用中的复杂需求。针对这一问题,siiRL 框架通过灵活的配置设计,实现了多智能体协同训练的核心能力支撑,具体包括:支持多 Agent 对 critic 的共享或独占配置,适配不同训练模式;提供 Reward 共享机制,保障多智能体目标对齐;实现多智能体与环境的多轮交互,模拟真实任务流程;开放自定义环境与 Agent 数据处理接口,提升框架适配性。

为进一步提升多智能体训练的效率与稳定性,siiRL 2.0 版本针对智能体与环境的交互功能这一核心环节进行了针对性升级,我们基于Qwen2.5-3B-Instruct模型,使用Dual-Agent进行多轮交互训练,相比 Single-Agent 的GRPO 算法,在 DeepScaler数据集上取得了 10% 的效果提升:

新增多智能体间的多轮交互支持,可顺畅承载智能体间的动态协作与信息传递;

完善了与训练环境的闭环交互能力,不仅能实现多轮环境交互,还同步集成了 Reward 实时计算模块,让环境反馈与智能体决策形成高效联动,为多智能体训练的连续性、稳定性与训练效率提供更有力的技术支撑。

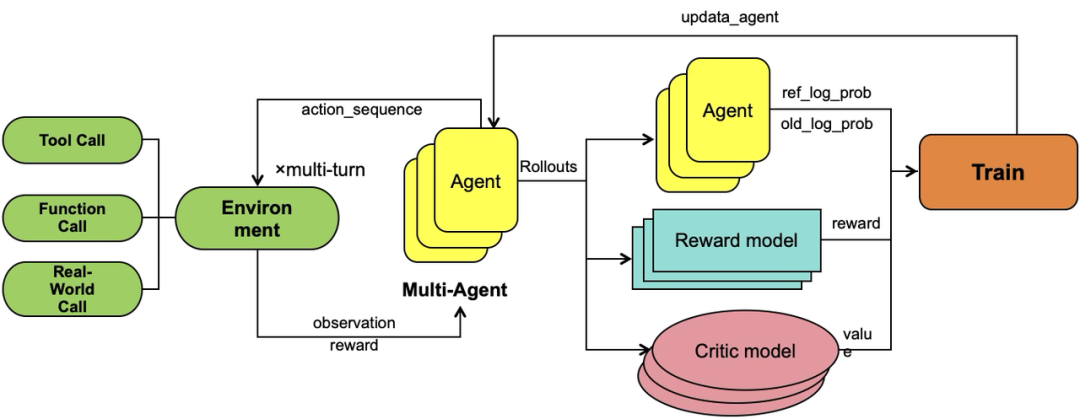

图 3:siiRL多 Agent 协同训练架构图

图 3:siiRL多 Agent 协同训练架构图

三、功能升级:集成Megatron后端,深度对接开源生态

siiRL 在 FSDP 基础上新增了 Megatron 训练后端支持,实现了 vLLM-Megatron 推理-训练后端的深度融合。这一升级为用户提供了具备高易用性与可扩展性的一体化后训练平台,基于 siiRL 与两大主要开源训练生态的对接,用户可直接利用社区最新优化,并进行灵活配置。我们针对稠密模型与 MoE 模型分别进行了相关适配与测试。

稠密模型:易用性层面,siiRL 能够实现 FSDP 与 Megatron 后端的低代码成本切换。性能层面,我们对 Qwen3 系列的稠密模型(1.7B/32B)进行了系统测试;两种后端下的训练吞吐与收敛速度表现出一致性,性能基本对齐,并且在相近配置下维持了稳定的 loss 曲线与显存占用。

MoE模型:基于 Megatron 后端,siiRL 内置支持五维(数据/张量/流水线/专家/上下文)并行的MoE后训练,在规模可扩展的GPU集群下稳定运行并高效利用显存。框架兼容自动专家分配与调度策略,有效缓解负载不均造成的计算瓶颈。实测表明,在 Qwen3 系列 MoE 模型上,siiRL 在相同节点规模下性能显著超越基线,在Qwen3-235B-A22B 训练中吞吐提升最高达到45%,同时保持稳定收敛。

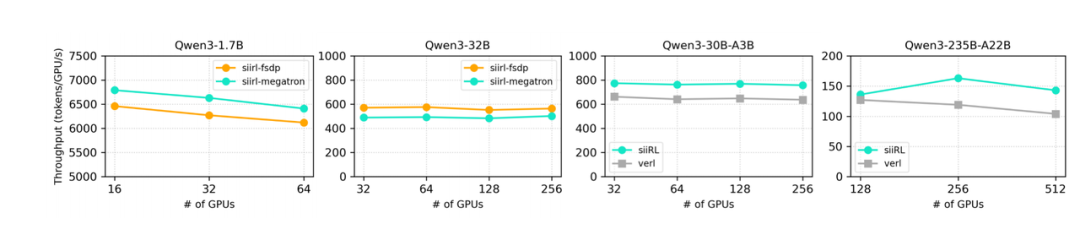

图4: siiRL在Qwen3系列模型上不同规格GRPO后训练任务的扩展性评估,展示了其多后端适配与高线性扩展能力

图4: siiRL在Qwen3系列模型上不同规格GRPO后训练任务的扩展性评估,展示了其多后端适配与高线性扩展能力

四、生态共建:联合主流厂商完善强化学习在国产卡上软硬协同优化

为繁荣国产强化学习生态,siiRL与华为昇腾、沐曦、阿里及基流科技等国产硬件厂商深度合作,打造了软硬件协同体系。各方不仅提供了内置驱动和加速库的官方优化镜像,极大降低了用户在国产平台的部署门槛:

华为团队:基于自研NPU和 Ascend CANN 底座以及完整的aclnn算子库与hccl高性能通信库,深度适配 Ray 分布式任务调度系统、PyTorch 训练系统以及 vLLM–Ascend 推理系统。依托昇腾 NPU 集群成功实现了高吞吐高效率的分布式强化学习系统。

沐曦团队:基于自研MXMACA软件栈,高度优化的vllm推理引擎及pytorch训练框架,快速高效的完成了siirl框架的适配。并且利用沐曦集群超节点的光互联能力,大幅提升了强化学习中rollout和training阶段的scale up能力,达到大规模强化学习的极致性能。

阿里云团队:基于自有国产算力的强大软件生态、PAI与工具链能力,深度融合云上与线下资源,同时依托阿里高性能算子库、通信库协议和分布式调度引擎等技术加持,实现高效、灵活且可扩展的并行计算能力。阿里针对siiRL 在超大规模下的并行任务调度实现了适配与优化,并完成对 vLLM、Ray 及 Torch 等组件的深度支持与调优。

基流科技团队:在 siiRL 中深度集成并优化了 Megatron-LM 训练后端。在千卡 GPU 规模下,千亿 MoE 模型的强化训练性能实现了近线性扩展,展现了框架全分布式架构的优秀性能与可扩展性。

仪电团队:以“算力基建+生态协同”双轮驱动,攻克国产异构集群的组网通信、运维难题,为强化学习等AI场景提供高吞吐、低延迟的国产化算力基座,助力国产AI生态实现从“可用”到“好用”的跨越。

此外,siiRL生态共建伙伴还有无限光年团队,他们聚焦于即将到来的Agent智能体时代,通过构建统一的工具协同与调用框架,为生态补上从“模型”到“应用”的关键一环,助力国产强化学习迈向更高级的决策智能。在此基础上,各家厂商还共同参与 siiRL 生态的持续建设,发布框架适配更新,推动国产软硬件协同创新。通过与产业链上下游的紧密协作,siiRL 已成为强化学习领域首个在多家主流国产芯片上实现端到端适配和千卡级规模化训练的开源框架,为国产AI生态的自主可控和可持续发展提供了坚实支撑。我们期待更多学术界和产业界的同仁加入,共同推动强化学习训练框架的发展。

图 5:siiRL生态共建合作伙伴

图 5:siiRL生态共建合作伙伴

五、未来蓝图:迈向通用人工智能的基石

siiRL在实现NVIDIA平台千卡线性扩展、并成功适配国产算力生态后,我们已为强化学习的大规模应用奠定坚实算力底座。立足于此,siiRL将聚焦前沿探索,致力于成为通往通用人工智能(AGI)道路上的关键基础设施。未来核心规划如下:

1. 探索具身智能场景:高效训练VLA大模型

我们致力于为前沿的VLA(视觉-语言-动作)大模型打造大规模的分布式强化学习解决方案。核心工作包括:

- VLA模型的深度适配与加速:为OpenVLA、π0.5等多样化VLA模型提供极致的性能优化。

- 大规模分布式方案:依托千卡级扩展能力,为VLA大模型提供高效稳定的训练支持,加速具身智能的应用落地。

2. 深化多智能体协同演进:从“复杂交互”到“智能规模化”

我们坚信,多智能体系统是解决超复杂现实问题的钥匙。为了真正释放其潜力,siiRL的未来演进将聚焦于以下几个核心方向,推动系统从基础协同迈向规模化的智能涌现:

- 复杂环境交互:赋予智能体群体在复杂环境中深度交互、并协同改变环境的核心能力。

- 分离式训练架构:以灵活的分离式架构为技术基石,支持大规模、异构智能体的高效独立优化与无缝协同。

- 探索多智能体Scaling Law:系统性地探索群体智能的Scaling Law,研究智能涌现的规律,解锁单智能体无法企及的能力上限。

3. 极致性能:持续引领框架性能与效率标杆

我们将持续打磨底层框架,保持性能领先:

- 软硬件协同设计:深化与华为昇腾、沐曦等国产硬件伙伴的合作,提供“出厂即适配”的强化学习框架。

- 算法与系统联合优化:探索RL算法与系统架构的联合优化,通过自动化策略搜索、资源动态优化等技术,榨干硬件性能,降低训练成本。

敬请期待我们下一次发布,也非常欢迎更多学术界和产业界的同仁加入,通过开源技术栈与人才培养,为全球AI基础设施注入中国创新力量。

上海创智学院携手来自31所顶尖高校的博士生及产业力量,以“建中研、干中学”人才培养模式,培养具备国际竞争力的实战型AI基础设施人才!开源周只是起点,开源生态现已启航,让我们以开放协作,加速技术跃迁,诚邀更多师生和全球开发者加入我们,共铸开放、创新的普惠AI基座!