面向情境智能的语音交互模型

如果你看过电影Her,一定还记得男主角西奥多在深夜街头与操作系统Samantha对话的场景。那不只是冷冰冰的语音合成,而是一种充满情感、能感知对话语境的互动:语气里有温度,停顿中有默契,甚至还能听出微妙的喜怒哀乐。这种富有人性化、拟人化、富有情境感知的语音交互,一直是人类对智能体的终极想象。

然而,现实中的语音合成技术长期受限于技术瓶颈。尽管近年来,文本到语音(TTS)技术已经取得了令人瞩目的进展,在单句、孤立段落的自然度和清晰度上已能媲美真人,但当它被用于连续、多轮的对话场景时,语音往往变得单调、呆板、甚至令人不适。AI播客和语音助手也常常陷入所谓的“恐怖谷”——声音虽然接近人类,但缺乏真实的情感和语境感知,让人感到别扭。

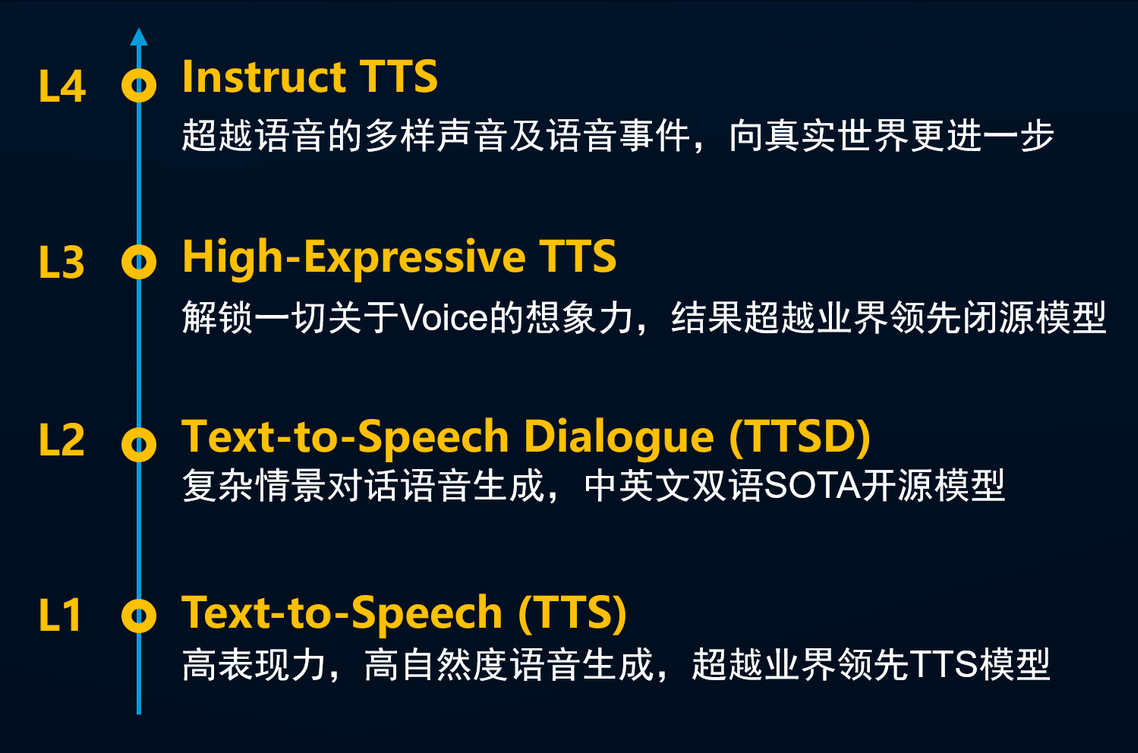

由邱锡鹏领衔,上海创智学院、复旦大学和模思智能联合组建的OpenMOSS团队正式发布MOSS-Audio系列模型!为了更好地区分语音模型的能力,团队将语音合成分为四个层级:L1实现高自然度语音生成;L2专注于复杂情景对话;L3突破声音想象力边界,迈向真实世界的多模态语音事件;L4则实现灵活多样的指令控制。每一级都代表了语音生成技术的飞跃。

团队首先训练了MOSS-Audio基础模型,并在此基础上实现L1-L4级的能力。它不仅破除了AI播客领域长期存在的“恐怖谷”魔咒,更通过对完整对话情境的把握,实现了超高拟人度、自然流畅的多角色对话合成,成为情境智能语音交互的里程碑。

从“朗读”到“表达”:重塑语音交互体验

传统的TTS模型更像是优秀的“朗读者”,只能基于单句生成语音,韵律、情感变化无法衔接到整个对话的上下文中。而在真实的语音交互场景里,语调、停顿、情绪的微妙变化常常是理解对话意图的关键。

MOSS-Audio不仅能够准确生成每位说话人的音色和语气,还能根据完整对话文本捕捉韵律变化和语调特性,从而实现了超越传统TTS的对话自然度和表现力。在一系列实测对比中,无论是情感的丰富度、语气的自然度还是音色的稳定性,MOSS-Audio模型都展现了媲美甚至超越商业产品的能力。

技术创新:一整套创新的技术架构

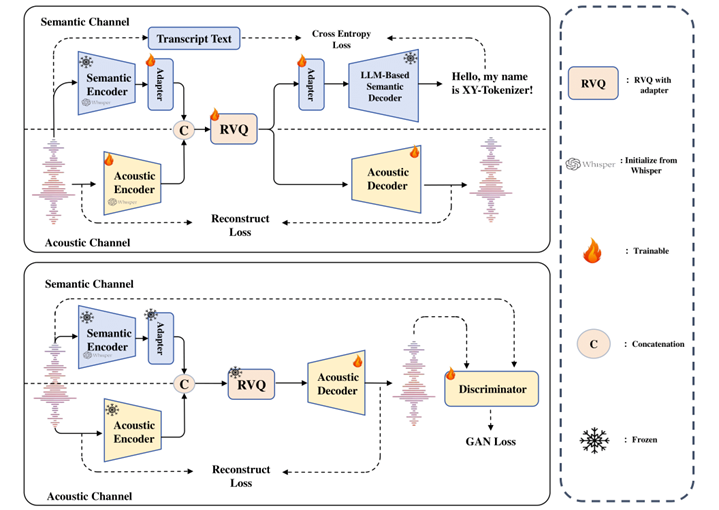

传统Codec无法同时兼顾语义与声学细节,而OpenMOSS 团队自研的XY-Tokenizer采用8层RVQ架构,创新性地压缩比特率至1kbps,同时保留了丰富的语音特征。这使得大语言模型能够在“会说话”的同时“表达情绪”,实现长达960秒的连续生成,避免了语音拼接的生硬感。 MOSS-Audio在音色克隆、语调表现、长对话稳定性等关键维度均达到业界领先水平。

打开情境智能的大门:AI真正走向人性化

在OpenMOSS团队看来,智能体的发展必须具备三个关键能力:知识、推理和交互。而交互,特别是情境化、主动化、全模态的拟人化交互,正是当前AGI进化的关键突破口。

因此,MOSS-Audio不仅仅是一款语音交互模型,更是“情境智能”的起点。它将大语言模型的推理能力与真实的语音情感、语境感知结合,向电影Her中的Samantha又迈进了一大步。未来,OpenMOSS团队还将陆续发布实时视频理解交互模型和具身人机交互模型,打造全面、强大的情境智能基座。

MOSS-Audio系列模型的模型权重、推理代码和示例将全面开源并支持商用。开发者、研究者和企业可以直接在GitHub和Huggingface获取资源,并基于此开展个性化定制和创新应用。

项目地址:https://github.com/sii-research/OpenMOSS

从早期的语音助手到今天的智能播客、虚拟主播,语音合成技术已经悄悄改变了我们的工作和生活。但只有当AI真正具备情境感知和拟人化的交互能力,它才能从“工具”进化为“伴侣”,走进每个人的心里。

正如电影Her告诉我们的那样,技术的终极目标从不是冷冰冰的功能堆砌,而是与人建立深刻的连接。

MOSS-Audio的发布,是迈向这个目标的关键一步。未来,当你和智能体在午夜长谈,当它轻声回应你的喜怒哀乐,那一刻,或许你会想起今天:机器开始让人类真正“听懂”自己。