为什么Llama在强化学习上总是不如Qwen?强化学习时代我们更需要什么样的基模?在深入探索这一问题的过程中,上海创智学院、上海交通大学的研究团队发现了更深层的秘密:现有大模型训练技术栈("预训练→微调→强化学习")已显局限。团队提出的"预训练(Pre-training)→ 中期训练(Mid-training)→ 扩展强化学习(RL Scaling)"新范式,不仅解决了Llama的问题,更为整个行业指明了方向。

研究团队首次系统性分析"什么样的基模更适合RL Scaling",开创Mid-training训练范式,自研并开源750亿tokens超高质量认知数据,成功让Llama在数学推理任务上追平Qwen2.5水平,实现完美逆袭。这一突破重新定义了下一代基模的构建思路:不再是简单的数千样本RL训练,而是Pre-training与RL Scaling的协同设计;不再依赖现有开源数据,而是自制数百亿高质量训练tokens。

值得一提的是,仅预览博客发布两个月内,尽管数据集尚未正式开源,就已吸引字节跳动、微软、AI21 Labs、Zyphra等国内外顶尖机构广泛关注,阿里千问、月之暗面、阶跃星辰等知名团队研究人员纷纷主动交流探讨。

论文链接:https://arxiv.org/pdf/2506.20512

GitHub仓库:https://github.com/GAIR-NLP/OctoThinker

Hugging Face:https://huggingface.co/OctoThinker

数据集链接 (700亿tokens):https://huggingface.co/datasets/OctoThinker/MegaMath-Web-Pro-Max

博客:https://tinyurl.com/OctoThinker

RL训练中的“Llama困境”:是偶然还是必然?

大型语言模型(LLMs)通过思维链(CoT)结合大规模强化学习,在解决竞赛级数学问题等复杂推理任务上取得了显著进展,OpenAI的o1、o3以及Deepseek-R1的成功都印证了这一点。然而,多数开源社区的“Aha Moment”复现和研究工作中都仅在Qwen模型上做出了效果;作者们在简单的RL实验上也发现了这点:Qwen系列模型在RL训练中表现出色,而Llama系列模型却常常出现过早预测最终答案、输出重复内容等异常行为,导致RL效果不佳。

这引出了Octothinker尝试探索的一个根本问题:是什么根本因素导致基础模型在RL训练中表现出截然不同的行为?研究团队相信,深入理解这一点,对于连接预训练与RL推理可扩展性的科学基础至关重要,也将指导未来更适合推理型RL的基础模型设计。

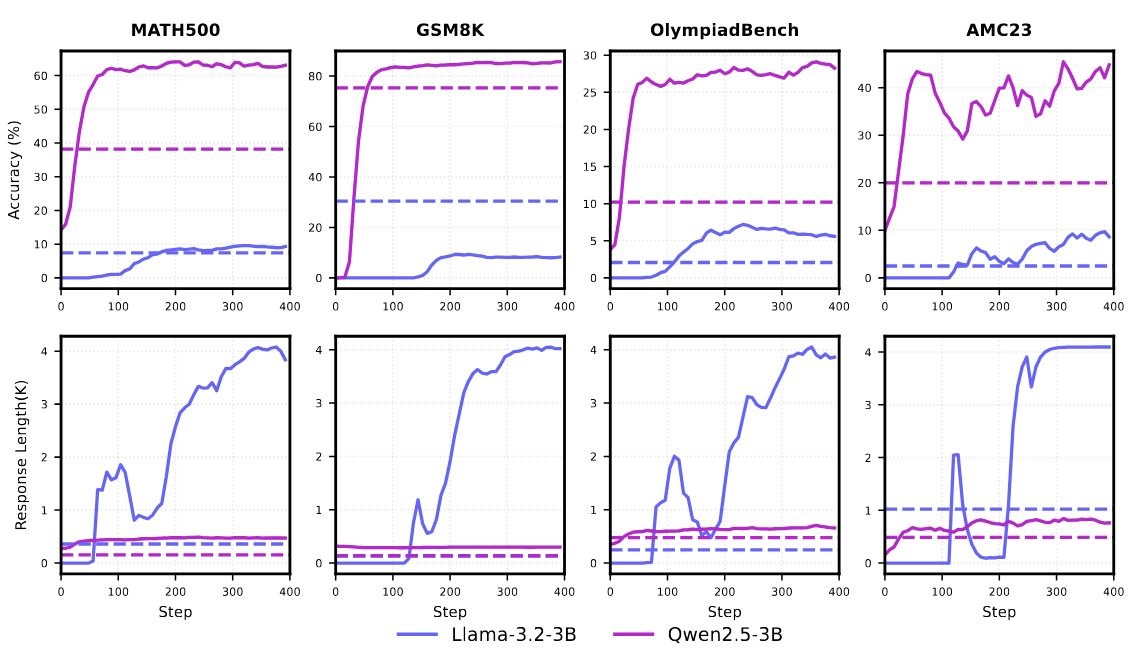

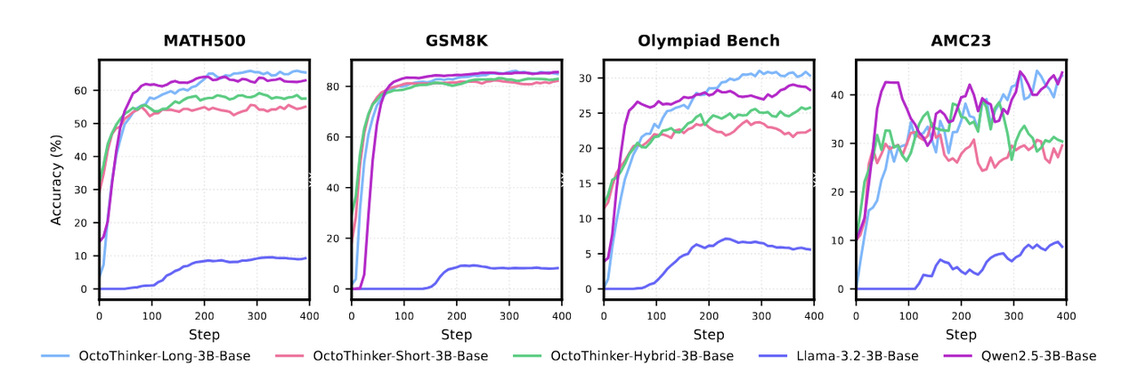

图:Llama系列模型和Qwen系列模型在RL训练上的行为区别极大。

解密Mid-training:让Llama“大放异彩”

为了回答和尝试解决这个关键问题,研究团队聚焦于数学推理这一广泛关注的领域,对Llama模型进行了一系列大规模且可控的中训练(mid-training)干预实验。

对于中期训练的定义: 鉴于目前尚无精确且广泛认可的定义,研究团队在本文中尝试为 “mid-training” 提出一个简明而严谨的定义。该术语最早出现于 2024 年中期的一则 OpenAI 招聘启事。Mid-training目前的定义是预训练(Pre-training)和后训练(Post-training,包括SFT/RLHF/RLVR等)之间的中间阶段,同时所花费的计算量和数据量也介于二者之间,旨在通过调整数据质量和分布(以及修改模型架构来提升推理效率),实现特定目标,例如领域扩展、长上下文增强或为后训练做准备。除此之外,此前开源社区中也有关于该术语的介绍博客,可见:https://vintagedata.org/blog/posts/what-is-mid-training 。

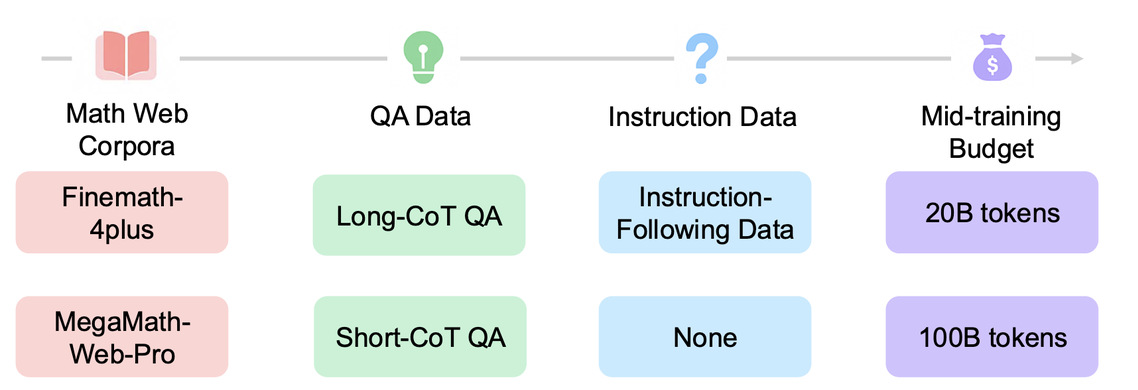

可控实验来定位中期训练的关键因素

对于大规模(例如大于百亿级别 tokens的训练任务),通常大家都不会做过多的消融实验(即通过控制单变量的不同来观察实验结果),而是堆叠更多的数据。然而,研究团队却认为这正是社区当下需要的一些实验结果。为此,团队进行了仔细的分析,从训练语料的质量、QA数据的格式、指令跟随数据的介入、中期训练规模的大小等多方面进行了可控的对比实验。

研究团队通过大量可控实验发现了以下几个潜在的因素:

高质量数学预训练语料至关重要!像MegaMath-Web-Pro和本次构建的MegaMath-Web-Pro-Max(超700亿Tokens)这样的高质量数学语料库,对Llama模型在RL训练中的表现有着显著提升。相比之下,FineMath-4plus等语料库效果甚微,甚至导致模型出现异常重复输出。

QA格式数据锦上添花,但长CoT需谨慎。引入QA格式数据能进一步改善RL性能,但如果直接注入长思维链(Long CoT)数据,可能会导致RL训练不稳定,出现性能骤降和响应长度暴增。

指令遵循数据是“稳定剂”。少量高质量的指令遵循数据能有效激发QA数据的潜力,并有助于稳定RL训练过程中的响应长度增长,使其更为平滑和合理。

精巧的RL策略不可或缺。针对长CoT带来的挑战,研究团队改进了RL提示模板,并采用了渐进式最大响应长度调度器,有效稳定了训练,确保了模型行为的一致性。

Scale Mid-Training is all Llama need!实验表明,增加中训练的token预算(从200亿到1000亿tokens)能够持续提升下游RL性能,即使这些提升不总能立即体现在基础模型的标准评估指标上,也凸显了RL阶段能力的潜在增长。

自建语料库 MegaMath-Web-Pro-Max:优上加优

在准备语料时,团队还发现了另一个问题,即开源高质量语料的缺乏。以预训练语料为例,目前最高质量的数学语料MegaMath-Web-Pro包含了不到20B tokens,但如果混合质量稍低的FineMath语料,则容易出现RL训练时的不稳定。

为了支持大规模消融研究和中期训练,研究团队创建了MegaMath-Web-Pro-Max (超过700亿高质量推理认知tokens)。该语料库通过一个高效的分类器从 MegaMath-Web中召回文档,并进一步利用一个大语言模型进行精炼构建。具体而言,研究团队从 MegaMath-Web 语料库中按文档的年份分层,均匀随机采样了数百万篇文档,并使用 Llama-3.1-70B-instruct 对其进行标注。每篇文档根据其在数学学习中的实用程度,被打分为 0 到 5 分,评分过程使用特定的评分提示(见论文附录)。研究团队采用启发式方法从模型的评论中提取评分:得分低于 3 的文档被标注为负例,得分在 3 分及以上的文档被视为正例。研究团队观察到,现有的分类器(如inemath-classifier)在数据收集过程中对文本提取器的选择非常敏感。因此,研究团队训练了自己的分类器,并选择效率较高的fasttext作为分类器。与MegaMath的发现一致,研究团队发现预处理步骤对召回性能至关重要。研究团队的预处理流程包括将文本转换为小写、过滤过长的单词,以及去除换行符和多余的非字母数字字符。

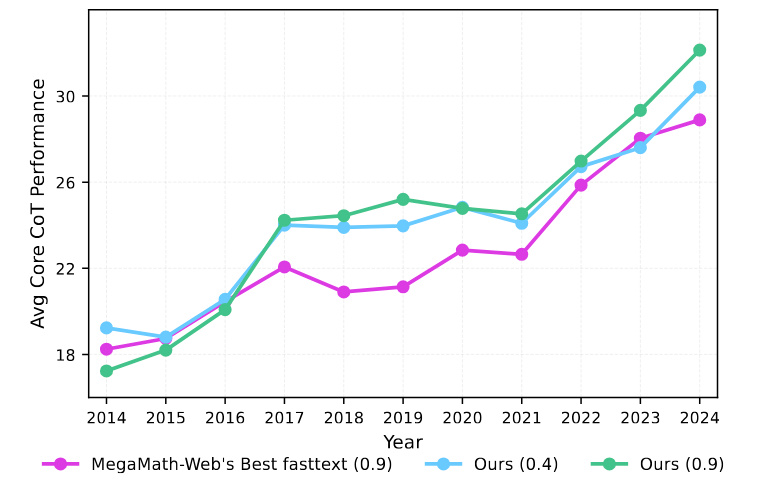

如下图所示,研究团队按照 MegaMath-Web提出的逐年数据集比较设定,评估了不同召回阈值下所召回语料的质量。召回阈值决定了数据质量与数量之间的权衡:较高的阈值(如 0.9)带来更高的数据质量,但保留的 token 数量较少。最终,研究团队选择了 0.4 作为召回阈值。

图:研究团队重新召回的数据与MegaMath-Web的按照Common Crawl年份逐年数据质量对比(不同的fasttext阈值)。

考虑到许多文档存在噪声大、结构差等问题,研究团队使用 Llama-3.1-70B-instruct 对文本进行了精炼,所用提示设计借鉴了MegaMath-Web-Pro。最终构建的MegaMath-Web-Pro-Max数据集包含的 token 数量约为 MegaMath-Web-Pro 的 5.5 倍。预训练过程中的实证评估表明,MegaMath-Web-Pro-Max在保持数据质量的同时,具备成为大规模中期训练基础语料的潜力。

此外,研究团队也尝试通过从常见数学问题求解数据集中引入长链式思维数据来扩充正例种子集合,以提升分类器召回推理密集型内容的能力。然而,这种方法最终仅保留了约 20B tokens,研究团队认为其规模不足,因此未被采用。

OctoThinker:多阶段训练 + 多分支实验,充分探索中期训练配方

基于这些前期的实验观测,研究团队最终提出了一个两阶段(“稳定-衰减”)中训练策略,旨在将Llama模型打造成一个更适合RL扩展的基础模型。

Octothinker的答卷:两阶段的中期训练配方

第一阶段(稳定学习率):使用高质量预训练语料,以恒定学习率对Llama模型进行2000亿token的训练,为模型打下坚实的推理基础。

第二阶段(衰减学习率):学习率开始衰减,同时引入不同的数据混合——短CoT、长CoT以及两者的混合,形成三个独立的“分支”:OctoThinker-Long、OctoThinker-Short和OctoThinker-Hybrid。

为什么要多阶段和多分支?

这样的策略有几个好处:

可以有效缓解token不足,衰减学习率往往可以让模型的训练loss下降更快,让模型更快速地学习到训练的数据分布,因此可以在少量数据上就生效,尽管Octothinker已经很详尽的优质语料的收集,但和闭源模型上万亿的训练数据相比还存在着差距。将高质量的数据放在衰减阶段进行训练,可以减小观测的开销。

可以通过一阶段将模型“适配”到特定的领域(如数学),然后在二阶段通过可控的实验对模型进行“分支”,观察不同的中期训练语料对RL学习带来的影响。

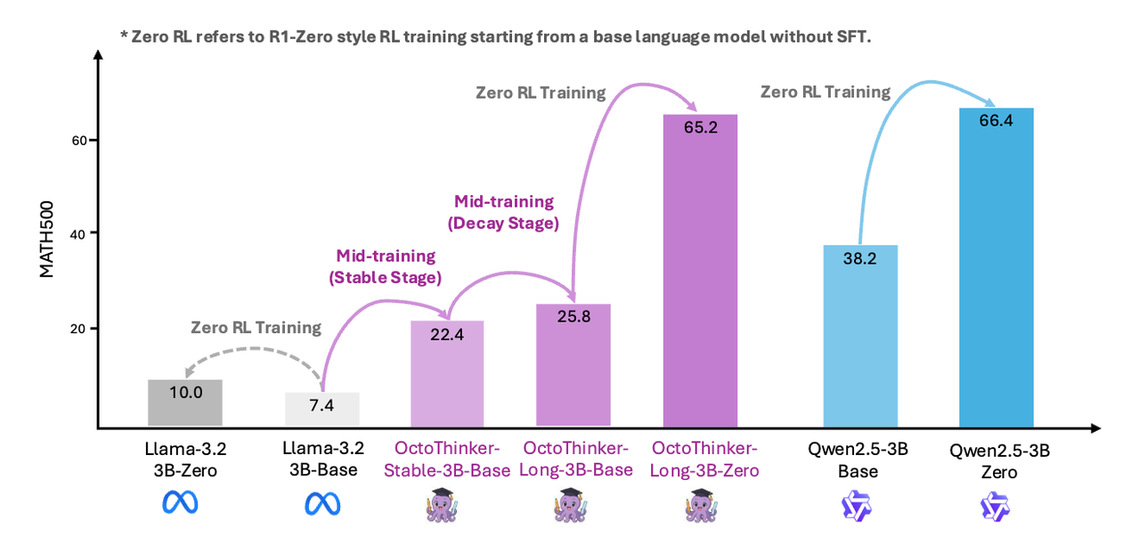

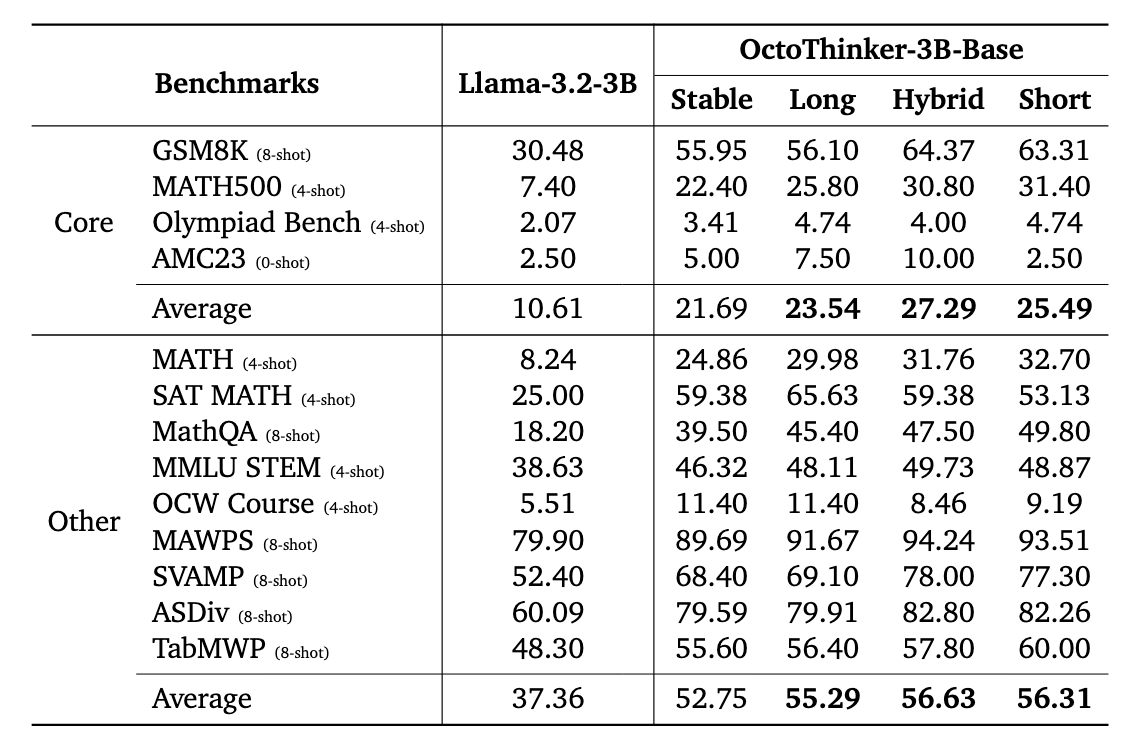

图:OctoThinker中期训练后的数学榜单表现跑分,图中所示为3B规模的模型结果。

最终,经过RL训练调优后,这些模型演变为OctoThinker-Short-Zero、OctoThinker-Hybrid-Zero和OctoThinker-Long-Zero。其中的short, hybrid, long,则代表了二阶段中注入的长推理数据的比例。

OctoThinker家族的表现:

在所有模型规模下,每个OctoThinker分支都比原始Llama基础模型有10%-20%的显著提升,并且持续优于稳定阶段的模型。最引人注目的是,OctoThinker-Long-3B-Zero在RL训练后,其性能与Qwen2.5-3B达到了同一水平,成功弥补了Llama和Qwen在RL可扩展性上的差距!这证实了大规模、推理密集型中训练在提升Llama模型RL能力方面的强大作用。

图: OctoThinker系列、Qwen-2.5、Llama-3.2在RL训练中的数学基准测试动态曲线。

展望未来:Pre-training for RL, 下一代推理AI的基石

OctoThinker的发布,为理解大型语言模型预训练与强化学习之间的复杂关系提供了一些深入的思考,更提供了一个可行的路径,成功地将Llama这样的通用基础模型转化为强大的、适合RL扩展的基础模型。研究团队表示,他们将开放所有的预训练数据、模型和训练脚本,以期推动开放的科学研究。正如论文所问:“我们到底需要什么样的基础模型?”OctoThinker希望能为迈向下一代具有强大推理能力的AI系统作出一份贡献。